データサイエンティストになるにはオススメの認定資格9選徹底紹介!

「ビッグデータ」時代において「データサイエンティスト」という職業はすでに、業界で最も注目となっている職業の1つであると言えるのでしょう。その年収は経験やスキルによってばらつきはありますが、約350万円から1000万円くらいまでだと言われています。ビッグデータをビジネスに活用したいと考えている企業は増えています。しかし、IT人材の中で特にデータサイエンティストは供給不足の状態にあります。

この背景において、ますます多くの人々がデータサイエンティストの仲間入りを求めています。それでは、データサイエンティストは一体どんな仕事をしているのか、そしてそうなるには取得しておくべき資格9選、最後データサイエンティストになるため無料学習サービス5選について紹介します。

データサイエンティストは、いわゆる「データ分析」、データの収集、照合、分析、および業界調査、データに基づく評価と予測を専門とするさまざまな業界の専門家を指します。

ビッグデータ時代において、企業が保有するデータは多岐にわたります。売り上げデータや顧客情報に関する情報など、さまざまな種類・形式のデータがあり、その量も年々増え続けています。他社との競争においてデータの重要性が見直されてきました。現在、世界500社の90%以上がデータ分析部門を設置しています。 IBM、Microsoft、Googleなどの有名な企業は、データサービスへの積極的な投資、データ部門の構築、データ分析チームの育成を行っています。政府や多くの企業は、データと情報が企業の知的資産と資源になり、データを分析および処理する能力がますます技術的な手段になっていることを認識しています。

データサイエンティストの仕事内容は簡単に言えば、「第一はデータを収集すること。第二は「データを分析すること」です。例えば、企業の売上データや顧客データなどさまざなデータからしかわからないことを分析して企業の事業戦略を作成しています。だが、そのデータの量があまりにも膨大なので、データサイエンティストはその膨大なデータを統計学やIT關係の知識で整理して営業状況や顧客画像などを分析することが仕事です。

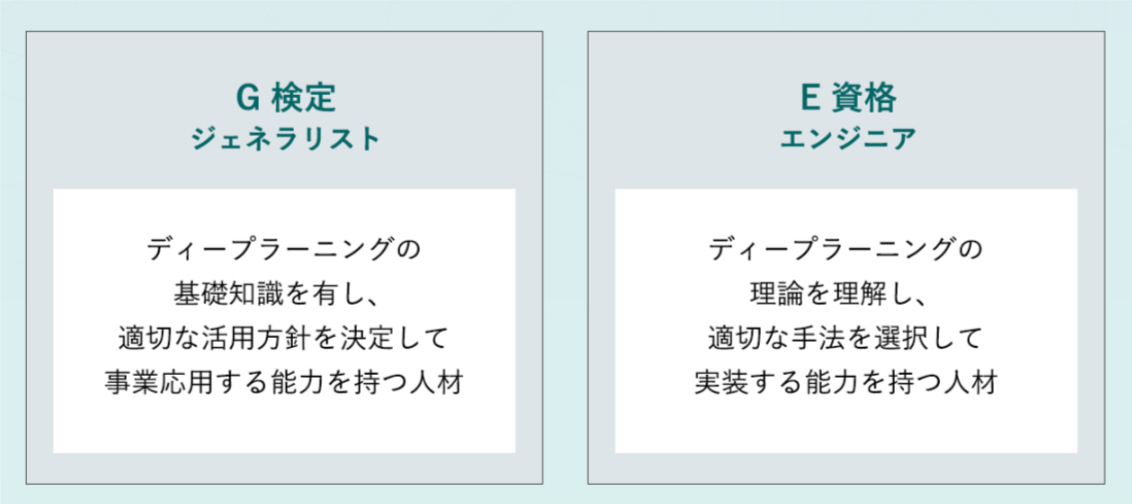

ほとんどのデータサイエンティストが持っている資格だと言われています。この2つの資格は有名なディープラーニング協会によっ2017年に設立されたものです。ディープラーニング協会はディープラーニングを事業の核とする企業が中心となり、ディープラーニング技術を日本の産業競争力を向上させるのを目的としています。

G検定とE資格はそれぞれ以下のような人材を検定しています。その違いは簡単に言えば、G検定はコンサルや上流エンジニア向け、主に基礎的な知識や事業に活かすための知識があるかどうかを図る目的で、一方E資格は完全にテクニカルなエンジニアや研究職向け、ディープラーニングを実装するエンジニアの技能を認定する目的だという印象があります。

試験名 :G検定

試験時期:年3回、3・7・11月

受験資格:制限なし

受験料(税抜き):一般 12,000円/学生 5,000円

合格率(参考):57%

公式サイト:https://www.jdla.org/business/certificate/

試験名 :E資格 (E"検定"は電気・電子系技術検定試験)

試験時期:年2回、2・8月

受験資格:JDLA認定プログラムを試験日の過去2年以内に修了していること

受験料(税抜き):一般 30,000円/学生 20,000円/JDLA正会員・賛助会員 25,000円

合格率(参考):69%

公式サイト:https://www.jdla.org/business/certificate/

特定非営利活動法人エルピーアイジャパン(LPI-Japan)が、オープンソースデータベース(OSS-DB)に関する技術力と知識を、公平かつ厳正に、中立的な立場で認定するIT技術者認定資格です。「Silver」(シルバー)と「Gold」(ゴールド)の二つのレベルがあります。

「Silver」と「Gold」はそれぞれ以下の人材を検定しています。

試験名 :OSS-DB Silver

試験時期:随時

受験資格:制限なし

受験料(税抜き):15,000円

合格率(参考):70%

公式サイト:https://oss-db.jp/outline/silver

試験名 :OSS-DB Gold

試験時期:随時

受験資格:Silver資格取得必要

受験料(税抜き):15,000円

合格率(参考):60%

公式サイト:https://oss-db.jp/outline/gold

データサイエンスだけでなく、ITに関係するすべての人に活用いただける試験として実施しています。「情報処理の促進に関する法律」に基づき経済産業省が、情報処理技術者としての「知識・技能」が一定以上の水準であることを認定している国家試験です。情報システムを構築・運用する「技術者」から情報システムを利用する「エンドユーザ(利用者)」まで、特定の製品やソフトウェアに関する試験ではなく、情報技術の背景として知るべき原理や基礎となる知識・技能について、幅広く総合的に評価しています。

試験名 :基本情報処理技術者試験

試験時期:年2回、4・10月

受験資格:制限なし

受験料(税抜き):5,700円

合格率(参考):20%

公式サイト:https://www.jitec.ipa.go.jp/

試験名 :応用情報技術者試験

試験時期:年2回、4・10月

受験資格:制限なし

受験料(税抜き):5,700円

合格率(参考):20%

公式サイト:https://www.jitec.ipa.go.jp/

データサイエンティストになるには最も有利な資格は「Python」でしょう。 Pythonエンジニア育成推進協会は、Python次期試験「Python3エンジニア認定データ分析ベータ試験」を、2019年8月27日~9月30日までの期間、全国のオデッセイコミュニケーションズCBTテストセンターで実施します。この試験は、Pythonを使ったデータ分析の基礎や方法を問う試験です。

試験名 :Python 3 エンジニア認定データ分析試験

試験時期:2019/8/27~9/30(初回)

受験資格:制限なし

受験料(税抜き):一般人1万円/学割5千円

合格率(参考):20%

公式サイト:https://www.pythonic-exam.com/

データサイエンティストは、文字の他にも画像や音声などのデータを取り扱います。そのため、データサイエンティストには画像処理に関する知識やスキルが必要です。この試験は画像処理の技術に関する専門的な理解と、ソフトウェアやハードウェア、システムの開発に知識を応用する能力が図られので、難易度がかなり高いと言われています。

試験名 :画像処理エンジニア検定 エキスパート

試験時期:年2回、7・11月

受験資格:制限なし

受験料(税抜き):6,600円

合格率(参考):45.4%

公式サイト:https://www.cgarts.or.jp/kentei/about/img_engineer/index.html

データを分析する上では、統計学の存在は避けられないでしょう。「統計検定」とは、統計に関する知識や活用力を評価する全国統一試験です。

データに基づいて客観的に判断し、科学的に問題を解決する能力は、仕事や研究をするための21世紀型スキルとして国際社会で広く認められています。レベルは、「4級〜1級」まで5つの段階がありますので、それぞれの料金も異なります。

試験名 :統計検定

試験時期:年2回、6・11月(1級は11月のみ、準1級は6月のみ、ほかは2回受験できる)

受験資格:制限なし

受験料(税込み):3,000〜10,000円

合格率(参考):20%〜64.6%

公式サイト:http://www.toukei-kentei.jp/

ORACLE MASTERとは、世界的にも知られている大企業オラクルが公式に運営する「Oracle Database」シリーズを扱う技術力を認定する資格です。試験ではデータベースの管理/運用のほか、SQLの習熟度を問う問題が出題されます。SEやプログラマーの間でも人気のベンダー資格なので、取得を目指す方も多い資格です。レベルはBronze、Silver、Gold、Platinumの4つに分かれています。

試験名 :オラクルマスター

試験時期:平日/土日祝日(不定休)

受験資格:Bronzeだけ制限なし、ほかは前のレベル取得必要

受験料(税抜き):Bronze :40,200円

Silver :26,600 円

Gold :26,600 円

Platinum :238,000円

合格率(参考):20%〜64.6%

公式サイト:https://www.oracle.com/jp/education/index-172250-ja.html

ITパスポートは、ビジネスに欠かせない必須のツールとなっているIT・情報技術に関する基礎的知識を証明する資格です。情報技術に関する基礎的な知識のほか、経営・財務の基本など、それぞれの分野における基礎的な用語・概念の理解を総合的に証明でき、より上位の情報処理技術者試験への足がかりとしても人気の国家資格です。

試験名 :ITパスポート

試験時期:随時

受験資格:制限なし

受験料(税抜き):5,700円

合格率(参考):50%

公式サイト:https://www3.jitec.ipa.go.jp/JitesCbt/index.html

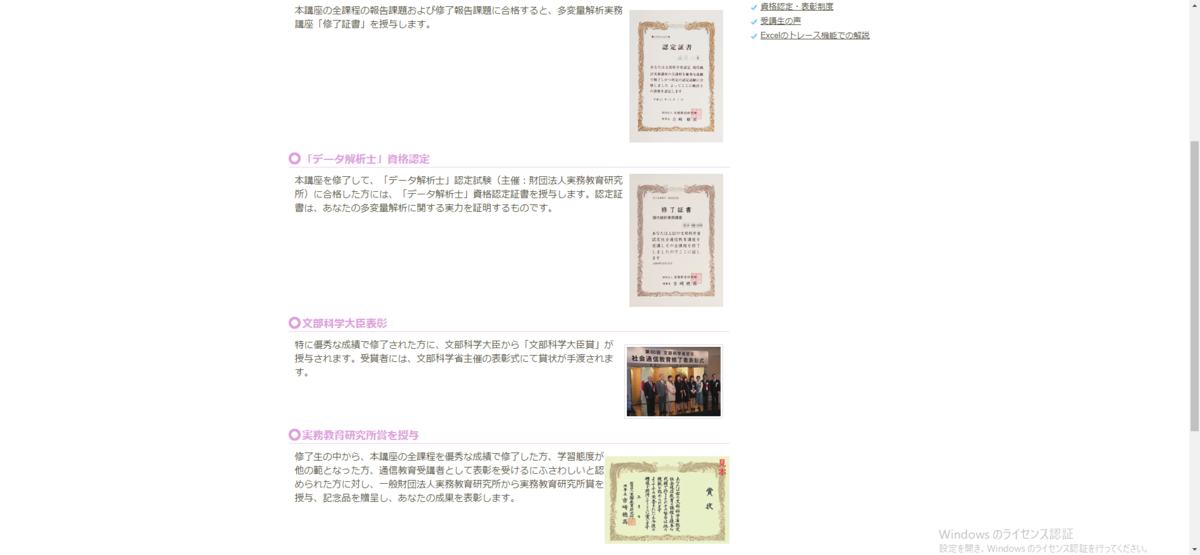

統計士・データ解析士は、実務教育研究所の通信講座を修了することで認定される統計資格です。統計士は「現代統計実務講座」、データ解析士は「多変量解析実務講座」に対応し、資格認定のほか、文部科学大臣賞や実務教育研究所賞など、表彰制度も充実しています。統計関連の通信教育としては日本で唯一の文部科学省認定講座で、仕事で忙しい方も無理なく学習できる点が人気です。

試験名 :統計士・データ解析士

試験時期:随時

受験資格:一般財団実務教育研究所の「現代統計実務講座」を受講する必要

受験料(税込み):講座:約5万円/試験:5千円

合格率(参考):50%

公式サイト:http://www.jitsumu.or.jp/courselist/analyze/analyze-ertified#prize

Aidemy は、AI エンジニアになるためのオンライン学習サービスです。Python入門から、ディープラーニング、自然言語処理など、有名な人工知能技術を実際にコードを書きながら習得できます。無料範囲はPython入門、機械学習入門、ディープラーニング基礎です。

初心者〜中級者向けのプログラミング学習サービス「paiza(パイザ)ラーニング」。 面倒な環境構築が不要で、PCとインターネット環境さえあればすぐに学習が始められます。 Java、Python、Ruby、PHP、Cなどのプログラミング言語を、わかりやすい3分動画と豊富な演習問題で基礎からしっかり学べます。初心者にとってとても優しいです。無料範囲はPython3入門編、C#入門編、C言語入門編です。

本チュートリアルは、初学者が始めやすく挫折しにくいよう工夫されています。ディープラーニングフレームワークの活用に必要な数学やプログラミングを基礎から機械学習の理論、ディープラーニングを基本から実践まで紹介するすべて無料です。初心者の方には段階的に理解していくことができます。

Octoparseはデータ取得に役立つ無料スクレイピングツールです。無料版だけでもデータを簡単に取得することができます。大切なデータ分析に時間がかかりますので、できるだけデータ取得の作業を簡単に済みたい方にオススメです。

この記事はデータサイエンティストになるには取得しておくべき資格9選と無料学習講座5選について紹介しました。データサイエンティストになりたいと思う方はぜひ本記事をご参考いただければ幸いです。

しかし、資格を取っただけではあくまでも本から学んだ知識なので、人それぞれなのでそれほど実践に活かせるかどうかがわからないです。やはり、資格をとってから実践に生かして経験を積んでいくことが大切です。

参考記事:

https://www.torikun.com/entry/datascientist-qualification/#i-8

https://career-picks.com/license/datascientist-shikaku/

2019年に知っておくべきオープンデータソース70選

ほとんどの人は、ビッグデータの収集は大変な仕事だと考えていますが、そうでもないと思います。実際にはオープンデータソースがたくさんあり、誰でも利用できます。ここでは、政府機関、医療・健康、 金融・経済、ビジネス・企業、ジャーナリズム・メディア、不動産・観光、文化・教育などに関するオープンデータソースを70選まとめました。

一、政府機関

1.日本総務省統計局: 日本総務省統計局、統計研究研修所の共同運営によるサイトです。国勢の基本に関する統計の企画・作成・提供、国及び地方公共団体の統計職員に専門的な研修を行っています。

2.DATA.GO.JP: これは日本各府省の保有データをオープンデータとして利用できる場をつくり、データの提供側・利用側双方にオープンデータのイメージを分かりやすく示すことを目的としたポータルサイトです。

3.Data.gov: 2009年5月に設立された、アメリカ政府機関データ公開ポータルサイトです。

4.Data.gov.uk: 2009年9月に設立された、イギリス政府のオープンデータポータルサイトです。

5.米国国勢調査局: このサイトは、人口、経済、教育、地理などを含む米国市民の生活に関する政府の統計情報です。

6.The CIA World Factbook: CIAが世界各国の地図とともに毎年公開している、国別政情情報です。

7.Socrata: データポータルやデータカタログのクラウドシステムを提供しています。

8.European Union Open Data Portal: 欧州委員会出版局(Publications Office of the European Union)によって管理運営されているデータベースで、ユーロスタット・地域委員会・欧州委員会競争総局など欧州連合及び欧州委員会の各機関によるパブリックデータを収録しています。

9.Datacatalogs.org: 各国で公開されているオープンガバメントデータに関する情報を登録・検索できます。200以上の地方、地域、国内のオープンデータのカタログが、世界中からの広範囲なデータリストになることを目指しています。

10.アメリカ国立教育統計センター(NCES):2010年秋に、全米の大学等3,689機関の図書館を対象として行った調査の結果をまとめたもので、サービス、スタッフ、コレクション、電子的なサービス、情報リテラシー、予算等に関するデータが含まれています。

11.UK Data Service: 国勢調査をはじめとする経済学・社会科学分野におけるデータを登載し、学術界・産業界・政府機関等における研究者をサポートすることを目的としています。

12.統一犯罪白書(UCR): 米国連邦捜査局(FBI)が毎年発表する米国内での犯罪に関する報告書です。

二、医療・健康

1.日本保健衛生(厚生労働統計一覧): 日本国内の医療施設や労働者、健康の保持などに関するデータを提供しています。

2.介護事業所・生活関連情報検索: 日本全国の介護保険サービス事業所の情報を提供しています。

3.アメリカ食品医薬品局(FDA): 食品や医薬品、さらに化粧品、医療機器、動物薬、たばこ、玩具など、消費者が通常の生活を行うに当たって接する機会のある商品についてのデータを更新しています。

4.ユニセフ: ユニセフは、世界中の子供の状況に関する情報を収集しています。

5.世界保健機関(WHO): 世界各国の政府と保健医療政策行政機関から報告を受け、世界各国、大陸地域別、世界全体の統計データベースを公開しています。

6.Healthdata.gov: 医療データの公開サイトで、公開されているデータは、公共機関から提供されるデータだけでなく、民間の医療機関から提供されるデータなど、200以上のデータセットが公開されています。

7.国民保健サービス(NHS): イギリス国民医療サービスの健康データセットです。

三、金融・経済

1.世界銀行: 世界銀行はデータ公開イニシアティブにより、約8000の開発指標を無料公開しています。

2.国際通貨基金(IMF): オンラインの経済データを無料で一般に公開していて、ユーザーは、大部分のIMF加盟国の全経済セクターを網羅した豊富なマクロ経済データにアクセスすることができます。

3.UN Comtrade Database: これは国連加盟約200の国や地域の統計機関によって報告された、詳細な輸出入統計のデータベースです。1962年から最新年までの、10億以上のレコードを含む最も包括的な貿易のデータベースが使用可能です。

4.Global Financial Data: 300年をカバーする60,000社を超える企業のデータにより、グローバル経済の紆余曲折を分析するためのユニークなソースを提供します。

5.Google Finance: 株価やチャート、金融ニュース、為替レートなどの投資関連情報をリアルタイムで入手できます。

6.Google Public Data Explorer: 大量の公共データから必要なデータを簡単に探してグラフ化できるツールです。

7.アメリカ合衆国経済分析局(BEA): アメリカ合衆国の経済についてのいくつかの重要な統計を提供し、最も注目される統計は、アメリカの国内総生産で(GDP)に関するレポートです。

8.Financial Data Finder(オハイオ州立大学): 金融データに関する膨大なリンク集を提供しています。

9.全米経済研究所(NBER ): 1973年6月以降のアメリカの景気動向や世界的な金融・経済動向などの調査報告書が収録されています。

10.米国証券取引委員会(SEC): 委員会に提出された企業財務報告書から抽出された情報のデータセットです。

11.Visualizing Economics: アメリカの経済をさまざまな角度からグラフ化した情報です。

12.Financial Times: 世界53の都市に600人以上の記者を擁し、国際ビジネス・金融・政治の分野で正確なニュースと分析を提供しています。

四、ビジネス・企業

1.Amazon API: これはAmazon自分のデータベースにアクセスするための出入り口で、Amazonから商品情報、在庫情報、注文情報などを取得できます。

2.Googleトレンド: Googleが蓄積している膨大な検索データをもとにした、人気急上昇のキーワードや特定のキーワードの検索回数の推移をグラフで確認できます。

3.HubSpot: 見込み客を惹きつけ、リードに転換し、顧客化を促すためのインバウンドマーケティング及びセールスのソフトウェアです。

4.Moz: キーワード調査、リンク構築、サイト監査、ページ最適化の洞察を含むSEOに関する洞察を提供します。

5.SEMrush: SEO対策のための競合分析はもとより、PPCやSNSの分析などデジタルマーケティングに欠かせない機能がすべてそろったオールインワンツールです。

6.Content Marketing Institute: コンテンツマーケティングに関する最新のニュース、研究です。

7.LinkedIn: ビジネス特化という性質を利用して、企業の人材採用や、個人の求職活動に利用されます。登録メンバーは5億人を超し、ビジネス情報を見つけることができます。

8.法人番号と企業情報: このサイトでは、前月末時点に公表している法人の最新情報を、全件データファイルとして提供するとともに、新規設立法人等の新たに法人番号を指定した情報、商号や所在地の変更及び閉鎖に関する日次の異動情報を差分データファイルとして提供しています。

9.OpenCorporates: 法人データのオープン化をグローバルに進めている世界最大の法人データベースサイトです。

10.Yellowpages: 地元の配管工、便利屋、整備士、弁護士、歯科医などの連絡先を見つけることができます。

11.Craigslist: 雇用、住宅、販売、サービス、地域社会、およびイベントのための地元の雑誌やフォーラムを提供しています。

12.iタウンページ: 日本全国のお店・企業の電話番号や地図、ルート案内まで全て無料で検索できます。

13.CertainTeed: アメリカまたはカナダの住宅請負業者、改造業者、設置業者、または建設業者を見つけることができます。

14.Manta: 製品、サービス、教育機会を提供する最大のオンラインリソースの1つです。

15.EU-Startups: EUのスタートアップに関するディレクトリです。

五、ジャーナリズム・メディア

1.NewYorkTimes API: このAPIにより1851年以降に掲載された280万記事が検索可能になります。

2.Associated Press API: .AP Content APIを使用すると、APポータルにアクセスしなくても、独自の編集ツールを使用してコンテンツを検索およびダウンロードできます。

3.Google Books Ngram Viewer: Google Booksに収録された数百万冊のデジタル化された書籍の全文データから特定の単語の出現頻度を年代別に検出することができるツールです。

4.Wikipedia: インターネット百科事典です。

5.FiveThirtyEight: これは、世論調査の分析、政治、経済、スポーツのブログに焦点を当てたWebサイトです。

6.Google Scholar: 学術用途での検索を対象としており、論文、学術誌、出版物の全文やメタデータにアクセスできます。

7.Social Mention: ソーシャルメディア上で人々が日常的に行っている会話や自然な行動に関するデータを収集し、ユーザーに言及する出版物のリアルタイム検索エンジンです。

8.Facebook API: Graph APIを使用して外部からデータを取得したり投稿したり更新したりなどのことができます。

9.Twitter API: Twitterのタイムラインやlist、検索などのデータを利用できます。

10.Instagram API: Instagram APIプラットフォームを使用して、フォロワーの取得、 ユーザー検索、自分以外のユーザーの写真取得などができます。

六、不動産・観光

1.Castles: 1981年に設立され、住宅の販売、賃貸管理、調査および価値算定などのサービスを提供しています。

2.土地総合情報システム: 不動産の取引価格、地価公示・都道府県地価調査の価格を検索してご覧になることができます。

3.土地代データ: 日本全国の土地価格データを掲載しています。土地価格相場、地域別平均値、地価ランキングが分かります。

4.サービス付き高齢者向け住宅: 全国のサービス付き高齢者向け住宅、全件が掲載されている唯一のサイトです。

5.日本旅行業協会: 世界旅行博の開催、キャンペーン情報の提供しています。

6.公共クラウドシステム(観光地情報): 日本全国の自治体の観光情報をオープンデータとして提供しています。

7.日本政府観光局(JNTO): 主要訪日旅行市場の基礎データを提供しています。

8.メリカ旅行業者協会(ASTA): 旅行専門家の世界最大の協会です。旅行代理店や、ツアー、クルーズ、ホテル、レンタカーなどの製品を販売している会社などのメンバー情報を提供します。

七、文化・教育

1.人文学オープンデータ共同利用センター: 情報学・統計学の最新技術を用いて人文学データの学術情報リポジトリです。

2.大学・大学院、専門教育: 学校教育に必要な情報を共有するポータルサイトです。

八、そのほか

1.Glassdoor: 企業評価やCEO評価、給与、福利厚生などの企業に関する口コミ情報を収集しています。

2.data.uni-muenster.de: 2011年に設立された、ドイツのミュンスター大学の科学データに関するオープンデータです。

データマイニングとは?その5つの特徴を知りましょう!

データマイニングとは、DM(Data mining)の省略で、統計学、パターン認識、人工知能などのデータを解析する技法を使って、情報管理システムなどに蓄積された膨大なデータの中から、パターンや相関関係などを見出し、マーケティングや営業などに活用するテクノロジーです。

データマイニングにとってデータを分析した結果では「おむつとビール」がその中の逸話として、よく知られていると思うが、興味のある方はデータマイニングに関する面白い記事10選を読んでもらいます。

そして、今回では我々がよく言っているそのデータマニングに関する5つの特徴を解説してみます。

1、膨大なデータに基づく

実際、ほとんどのデータマイニングアルゴリズムは小さなデータボリュームで実行でき、結果を取得できます。ただし、量がすくないデータの場合は、完全に手動分析で要約できる一方で、少量のデータは実際の世界の普遍的な特性を反映できないことがよくあります。ですので、データマイニングで正確的な結果を出すにはまず、膨大なデータを取得しかできます。Ocotparseという無料スクレイピングツールを利用すれば、何百万件のデータを正確的に収集してくれます。

2、高い信憑性を持つ

いわゆる信憑性とは「信用できる、または信頼できる度合い」を意味します。マイニングされたデータは事実に基づいて高い信憑性を持たなければならないです。単にその分野において地位や権力が高いオーラに左右されて、その人が言っていることが本当なのかを判断できず、真実から離れて行くことになるかもしれません。ですので、確実なデータに基づいて出た結論の方が信憑性があります。

3、データの裏側を見抜く

データマイニングとは、データから直接に伝われてくる知識ではなく、人が工夫してその中に隠されているものを発見することです。例えば、TableauやRAWGraphsなどの一般的なBIツールを使用するしか発見できない情報がたくさんあります。

4、未知性に富む

マイニングされた知識は、今まで誰も発見できない未知なものであるべきです。そうでなければ、単に専門家の言っていることを検証しただけです。新しい知識がどんどん発見されて、それを新しい技術に変えれば、世界を変えることになるかもしれません。

5、価値を持つ

マイニングの結果は、企業に直接的または間接的な利益をもたらさなければなりません。データマイニングはとても高級的に見えますが、実は役に立っていないという人もいます。これは単なる誤解です。一部のデータマイニングプロジェクトでは、明確なビジネス目標の欠如、データ品質の不十分、またはデータマイニング職員の経験不足などの原因で、データの最大価値を活かすことができません。しかし、データマイニングそのものの価値を最大限にすれば、成功したケースの多くは、データマイニングが実際に効率を改善するツールになり得ることも証明しています。

以上はデータマニングに関する5つの特徴でした。いかがでしょう。

今後のマーケティング活動において、大きなサポートになれるようなデータマイニングを導入する際には以上の5つの特徴をチェックしてから判断しましょう。きっとお役に立てると思います!

RPAとは?2019年オススメのRPAツール15選

今では、RPAという言葉は話題になっています。RPAは仮想知的労働者とも呼ばれ、働き方改革や人手不足を解決する手段として期待されています。そこで、今回はRPAとは何か、導入のメリット、オススメのRPAツールということを紹介したいと思います。

RPAとは?

RPAとはRobotic Process Automationの略で、「ロボットによる業務の自動化」と表現されます。RPAはこれまで人が手作業で行ってきた業務をロボットが代行、自動化することにより、業務プロセスの処理にかかる時間を短縮し、業務効率を向上させることができます。RPAを導入することで、以下のメリットを得られます。

1.コストを減少できる

2.業務を効率化できる

3.ミスを防止できる

4.人材不足に対応できる

RPAツール15選

企業の業務効率や人手不足の課題を解決するために、RPAツールの導入も加速しています。以下はRPAツールを15選まとめました。

1. UiPath

UiPathは、RPA業界で世界的なトップベンダーです。2017年に日本法人を設立して以来、日本で急速にシェアを伸ばしている注目RPAツールです。UiPathは機能が豊富にある自動化ツールを開発する環境を提供しており、簡単にロボットでの業務の流れが構築できます。業務の流れのシナリオ化は、ロボットにさせるアクティビティ(動作)をドラッグ&ドロップすることによって簡単にできるだけでなく、「レコーダー」という人の動作を見て自動化するものを使用するのみです。.Netがわからない初心者でも向いています。Micrsoft社のソフトやXAML書式にも適応できるできることが魅力の一つです。60日間の無料トライアルも提供しており、導入前のお試しも可能です。されに、非営利団体、教育期間、小規模企業(従業員250名/台未満、かつ年商約5億円未満)に無償でCE版(Community Edition)を提供しています。

2.WinActor

WinActorはNTTグループによって開発された純国産RPAツールです。サービスインフラ・ソフトウェア通信・金融などの業界でよく導入され、日本国内でシェアNo.1となっています。業務の手順を「シナリオ」として記憶し、同じ操作を何回でも繰り返し実行することができます。PC1台でスモールスタートから大規模導入まで幅広く対応可能です。Windows PC上で動く、パッケージソフト(Office製品など)からスクラッチ開発の独自システムまで、プログラミングスキルがなくても簡単に操作できます。60日間の無料トライアルも提供し、サポートも充実しているので、初めての企業にも安心です。

3. BizRobo!

国内における実績NO.1サービスとして高く評価されているBizRobo!はホワイトカラーの生産性を革新する、ソフトウェアロボット(Digital Labor)の導入・運用を支援するデジタルレイバープラットフォームです。ソフトウェアはインストールせず、Webサーバーを1台用意するだけで、複数のロボットを作成でき、それらを同時に運用することができます。そのため、大規模なウェブアプリケーションに適しています。また、ドラッグアンドドロップで、ロボットに覚えさせる業務フローの作成が容易にできるので、担当者がロボットを簡単に作ることができます。株価推移の管理・通販サイトの価格調査・在庫管理・商品登録などの作業によく利用されています。日本語によるトレーニングコンテンツも用意し、充実しています。

4. Autoブラウザ名人

Autoブラウザ名人は、ブラウザ上で行う定型的なルーチンワークをを自動化することで、業務の自動化・デジタル化を推進するRPAツールです。インターネットエクスプローラーの起動、取引先のWebサイトへのアクセス、ログオン、メニューやボタンのクリック、ログオフなどを自動化できます。インターネットを介した取引先とのデータ交換が飛躍的に効率化します。また、Excelや、さまざまなWindowsアプリケーションを利用した業務の自動化も可能ですので、業務の生産性が飛躍的に向上します。

5. Blue Prism

Blue Prismは、RPA の世界的リーダーとして18年以上の歴史を持つ老舗 RPA ツールとなっていて、高度な管理機能を提供するグローバルシェア No.1 です。Blue Prismは、内部統制を強化し、各事業部門に分散している RPA ロボットを一元管理することができます。運用管理者向けのダッシュボードによりロボットの稼働状況や様々なKPIが可視化されるため、「野良ロボ」化したロボットを捜索し、管理・修正することができます。サーバー集中管理型 RPA で、ロボットの実行ログだけでなく監査ログも取得できるため、ロボットの修正履歴の管理や、ロボットの更新に伴う新旧ロボットの比較が可能です。汎用性に優れていて、メインフレーム、Windows、Web などの各種インターフェースに対応するだけでなく、社内開発された API のない業務アプリケーションでも連携することができます。高度なセキュリティ機能も提供し、金融機関や医療機関などの規制産業においても、安全に利用することができます。

6. Automation Anywhere

Automation AnywhereはアメリカでのシェアNO.1の実績を持ちサーバー型のRPAツールです。機械学習と自然言語処理技術を用いて柔軟な動作が可能でき、定型業務だけでなく、一部非定型業務の自動化までを実現できます。Automation Anywhereは、ソフトウェアボットと共に構成されWindows 環境で稼働し、主な設定は、タスクエディタにより、 自動化したい作業ステップを記録し、スクリプトを作成します。Web サイトのデータ抽出やスケジュールされたファイル転送などの一般的なタスクを自動化する数十種類の事前構築タスクテンプレートが含まれています。光学式文字認識(OCR)やJava との統合などの高度な機能を備えたオプションの統合パックを購入することで、幅広い外部アプリケーションと統合することができます。高いセキュリティ基準にも対応可能です。また、中央管理型のシステムを提供しており、ロボットの一元管理を可能にします。現在、コミュニティ版がリリースされ、スモールビジネス従事者、開発者の方等が無償でAutomation Anywhereを使えることになりました。

7. NICE

NICEは、元々コールセンター業界から生み出したRPAツールで、顧客管理を効率化しています。NICEは単なるRPA製品ではなく、半自動ロボ、業務プロセス可視化ツールを含めた総合的な業務効率化ツールです。光学式文字認識(OCR)やチャットボット、機械学習などの技術を使うので、業務プロセスの中で繰り返し作業を自動化していきます。デスクトップ型のツールだけではなく、サーバー上の処理作業にも対応できます。デスクトップモニタリングという機能もあり、オペレーターが顧客と対話している際に音声を認識し、顧客の属性、ステータス、購入等のメタデータを自動作成することが可能です。

8. WorkFusion RPA Express

RPA ExpressはアメリカのWorkFusion社が提供している無料のRPAツールです。コードの必要はなく、ドラッグアンドドロップで作成可能し、録音ボタンを押すだけでタスクを自動化できます。データの収集と分析を行うControl Towerではボット・人・プロセスの管理や進行状況・パフォーマンスを一括管理できるため非常に便利です。日本語対応なしですが、無料トレーニングを提供しているので、小規模の企業やRPAを試しに導入してみたい企業におすすめです。

9. ROBOWARE

ROBOWAREは、定型化された業務のオペレーションを自動化できるRPAソリューションです。従来のRPAと比較して、柔軟なカスタマイズが可能であるため、自動化できる作業範囲が広がり、より複雑な作業への対応が可能になりました。ROBOWAREは画面上に表示されるテキストや画像をそのまま認識でき、キーボードとマウスを使って操作する動作を代行します。PHP、 Ruby、Java、C#による開発ができ、それぞれの言語に対して多数のAPIが揃えられており、自社内での開発も可能です。

10. SynchRoid

SynchRoidはソフトバンクが開発したRPAツールです。その特徴は「ITスキルが低い人材でも開発できるシンプルなRPA」です。従来、RPAとは開発画面が難しく専門的なスキルが要求されることの多い製品でした。そこでSynchRoidでは、開発画面をGUI(グラフィカル・ユーザー・インターフェース)で提供し、情報システム従事者でなくとも開発者として自動化ロボットを作り出せます。実行環境は、デスクトップおよびサーバーどちらも選択可能です。RPAの導入支援やトレーニングなどのサポートは充実し、多くのシステムとの連携が可能です。

11.Verint

Verint RPAは、操作対象の認識方式として特許技術である画面イメージおよびOCRによる文字認識を組み合わせた独自技術を採用し、対象アプリケーションの制限を最大限に減少させています。また、操作方法を監視・自動記録する機能や、定型のコマンドを選択リストから選ぶことで動作を補完する処理を追加して作成する仕組みを持っているようです。さらに、業務プロセス分析ソリューションによりデスクトップ作業を常時監視し、手順のトラッキングと可視化により、業務プロセスの定義やモニタリングを自動的に行うことも可能とのことです。

12. Pega Robotic Automation

Pegasystems は、自社のBPM やCRM を補完する目的でRPA のOPENSPAN 社を買収し、ロボット、分析、ケース管理を統合して提供します。Pega の統合 Pega Platform™ 上に構築された適応型クラウド設計ソフトウェアでは、戦略的なビジネス ニーズに合わせてアプリケーションを迅速に展開し、拡張し、簡単に変更することが可能です。「Pega Robotic Automation」には業界トップクラスとなるBPMプラットフォームの主要機能を搭載しています。業務の自動化と業務プロセス管理のデジタル化を、同時に実現することが可能になっています。

13. Octoparse

Octoparseはコーディングを必要としなく、クリックするだけでWebデータ抽出を自動化するRPAツールで、Webスクレイピングツールとも呼ばれます。従来、プログラミングや手作業でコピペすることでデータを収集しますが、データ抽出をよりやすくするために、OctoparseはAmazon、楽天市場、Twitterなど数多くのすぐに使えるWebスクレイピングテンプレートを提供しています。パラメータ(ターゲットWebサイトのURL、検索キーワードなど)を入力するだけで、データが抽出されてきます。クラウド型プラットフォームも提供するので、スケジュール設定が可能で、リアルタイムデータを自動抽出し、Webサイトの更新情報をいつでも入手できます。取得したデータはExcel、HTML、CSVのような構造化フォーマットで、またはご指定のデータベースに保存されます。自社にノウハウがないが、課題解決にデータを収集したい場合は、ぜひWebスクレイピングツールを試してみてください。

14. Redwood Software

Redwood Softwareは、デジタルプロセスの変換を加速し、業務中の手動作業のコストを削減します。ERP プロフェッショナルサービスの経験があり、Redwood robots は、Oracle やSAP のERP システムと連携して、物流や電子取引、財務などあらゆる分野での作業の効率化を実現します。お客様は、ソフトウェア、クラウド、アプライアンスなどの複数の導入オプションから選択できます。Redwoodの自動プロセスパッケージ(APP)は事前設定されて、エンドツーエンドのプロセスをシンプルすることができます。

15. Softomotive

Softomotiveは、RPA製品とサービスの人気の提供会社の1つです。企業が運用コストを大幅に削減し、効率を高め、生産性を向上させ、パフォーマンスを向上させるProcessRobotソリューションを提供します。構造化されたワークフローを整理し、データ品質を向上させ、人的ミスを排除し、優先順位の高い付加価値の高い計画に注力することができます。24時間365日、夜間、週末にかけて動作し、顧客の期待を超えて要求を即時に処理することができます。

まとめ

以上、RPAの紹介でした。少しではご参考になりましたか?RPAを活用することで、社内の業務効率を大幅に向上させることが可能です。自社にピッタリのRPAツールを導入して、業務を改善しましょう!

大企業がこれらの人気サイトからデータを取得している!ジャンル別24選

我々が現在にいる社会はすでに「ビッグデータ」という言葉があたり前のように見聞きする時代になりました。近い将来、テクノロジー、ビジネス、金融、法律、人々の暮らしなど、ビッグデータによって大きく変わっていくのでしょう。

それで、ビッグデータの中で最も重要なものとも言えるデータインテリジェンスは、既存のビジネス世界に新たな成長をもたらすだけでなく、さらに企業の意思決定を左右する役割にもなってくると思います。

そのような「ビッグデータ」時代においては、最新のデータを取得して分析し、マーケティングの動向を一番早く把握して対応できる企業だけがこの世に生き残れます。

では、この世に生き残れることを目指している企業にとっては、どのようなデータを取得しなければならないのかというと、これからこの記事で、大企業がデータを取得している人気サイトをジャンル別に紹介したいと思います。まだまだたくさんのサイトがあると思いますが、コメントをいただければ幸いです。

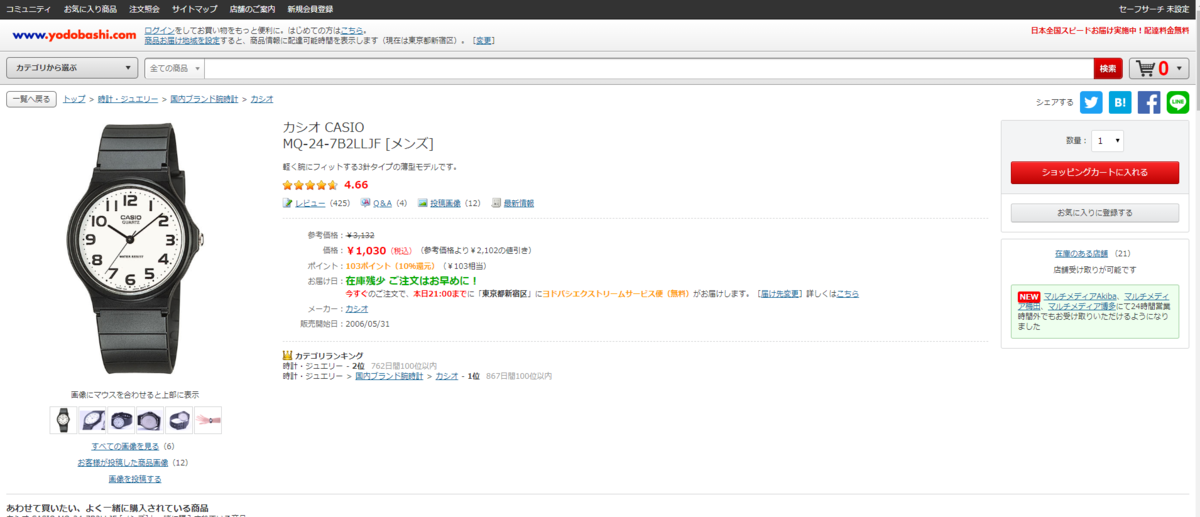

1. ECサイト(5選)

Amazon、楽天市場、ヨドバシカメラ、ZOZOTOWN、Yahoo!ショッピングなど

主なデータ:商品名、URL、価格、画像URL、ASIN番号、送料、カラー、サイズ、ブランド、店舗名、在庫、購入数、レビュー、スターランキングなど

データ用途:価格比較、競合調査

- アマゾン(Amazon)

- Rakuten

2. 転職求人サイト(4選)

主なデータ:会社ホームページ、会社名、会社情報、会社所在地、メールアドレス、掲載期間、仕事の内容、求めている人材、勤務地、給与、勤務時間、休日休暇、採用予定人数、待遇福利厚生など。

データ用途:企業調査、業界研究、競合調査

- マイナビ転職

- Doda転職

3. 不動産サイト(4選)

SUUMO、HOME’S、at home、マイナビ賃貸

主なデータ:物件名、住所、交通、販売価格、敷金、保証金、物件画像、土地面積、建物面積、築年月、階建、間取り、方角、車内施設、周辺環境、駐車場、契約期間、保険、問い合わせ先など。

データ用途:価格調査、不動産業界研究、競合調査、市場調査

- SUUMO

- HOME’S

- at home

- マイナビ賃貸

4. ソーシャルサイト(4選)

Facebook、Twitter、Instagram、Youtube

主なデータ:投稿者、投稿内容、いいね、コメント内容、コメント数、シェア数、グループ、投稿日、画像URL、ビデオURLなど。

データ用途:口コミ調査、世論調査、感情分析

5. 検索サイト(3選)

Google検索、Yahoo Japan、Bing

主なデータ:タイトル、ページリンク、内容概要など。

- Google検索

- Yahoo Japan

- Bing

6. 企業情報サイト(1選)

iタウンページ

主なデータ:企業名、特徴、住所、電話番号、会社詳細リンク、HPなど。

データ用途:営業リスト作成、企業調査

- iタウンページ

7. 暮らし・生活・口コミサイト(3選)

主なデータ:タイトル、スターランキング、レビュー件数、カテゴリー、HP、電話番号、場所など。

データ用途:関連情報取得、口コミ調査、価格調査、市場調査

- Booking

どうやってデータを取得するか?

それで、企業がどのようにこれらのサイトからデータを取得しているのかと疑問しませんか。

1. 全世界にわたって150万以上のユーザーが利用している便利なツールで、データ収集の自動化を簡単に実現してくれます。ビデオやチュートリアルなどが基本操作コースを準備してくれたので、素人には心配なく!

2. 前に述べた人気サイトから主なデータを抽出するタスクテンプレートもありますので、完全な素人でも、キーワードかURLかを入力するだけでデータをすぐ抽出できる。

3. 無料版でも1万件のデータ出力、有料版はデータ出力上限なし。Excel、CSVやデータベースへの出力、クラウドサービス、APIアクセスやスケジュール設定などもできる。

4. チームワークを必要とする企業には法人プランをオススメ!膨大なデータを抽出することを簡単に実現するだけでなく、そのデータをチーム内に共有することもできる。

いかがでしょう。素人の私でも、一ヶ月の時間を利用してOctoparseを上達できました。ここまで読んでくれたあなたはもっと短い時間で上達できるのではないでしょうか。早速お試してみましょうか。

クローラーエンジニアになるには?学習すべきことを解説

ビッグデータ・AIの台頭とともに、データ収集、活用の重要性が高まるようになりました。ビッグデータを収集するために、多くの企業は専門のクローラーエンジニアを採用しています。今回の記事では、「クローラーエンジニア」の仕事内容、学習すべきスキルについて解説したいと思います。

クローラーエンジニアとは?仕事内容は?

簡単に言えば、クローラーエンジニアはWebクローラーを開発するエンジニアです。以前紹介したとおり、Webクローラーとはインターネット上に公開されているテキスト・画像・動画などの情報を自動で収集し、データベースに保管するプログラムのことです。

クローラーエンジニアとして、ネット上掲載している情報を自動で収集できる「クローラー」プログラムを書かなければなりません。

多くの企業はデータを活用してビジネスチャンスにしていこうと取り組みを進めているでしょう。会社のビジネスによって、仕事内容もそれぞれです。

例えば、Google検索エンジンなどデータ集約型のWebサイトでは、数ミリ秒以内に特定のキーワードを含むページを提供できます。Webページをリアルタイムで見つけるのではなく、事前にスクレイピングして独自のデータベースに保存することは間違いありません。

また、価格比較など、情報比較を提供するWebサイトがあります。これは、Webクローラーを介してさまざまなショッピングWebサイトにある製品の価格をスクレイピングし、各ショッピングサイトの価格をまとめて表示します。ショッピングサイトの価格は時々変化しますが、比較サイトでスクレイピングされたデータは削除されないため、価格トレンドを提供することができます。

クローラーエンジニアになるには、学習すべきことは?

1. 少なくとも1つのプログラミング言語

コーディング基礎は、すべてエンジニアに不可欠です。実際、クローラーの開発は簡単な仕事ではなく、使用するプログラミング言語に精通し、関連するフレームワークとライブラリに詳しくすることが重要です。もちろん、スクレイピングの主流はPythonですね。

2. タスクキュー

クローリング作業が膨大な量のデータを処理するとき、システムに多大な負荷がかかり、システムは停滞するかハングアップするかして支障を来たす可能成があります。したがって、非同期分散処理できるタスクキューが必要です。タスクキューを使うと、複数台のマシンでワーカーを構成して分散処理を行うことで、高いスループットを発揮します。

後からワーカーにマシンを追加することで、処理性能とデータ保持容量をスケールアウトすることもできます。ワーカーがタスクの処理に失敗した場合、タスクキューはキューに再試行メカニズムを適用するため、タスクは限られた回数だけ再試行されます。

一般的に使用されるタスクキューサービスはKafka、Beanstalkd、Celeryなどです。

3. データベース

言うまでもなく、データを保存するにはデータベースが必要がです。ここではNoSQLのMongoDBをお勧めします。MongoDBはスケーラビリティが高く、容易にスケールアウト(水平スケール)できるので、大量のデータを高速に処理することが可能です。

4. HTTPとHTMLの知識

スクレイピングするのはWebページのデータだから、Webページの構造を理解する必要があります。

HTTPとはWebサーバとWebブラウザ用の通信プロトコルです。私たちはInternet ExplorerやGoogle ChromeなどのWebブラウザを使用してWebサイトにアクセスします。そもそもWebページの正体はHTMLタグを使って構成されている文書ですが、閲覧したいページや画像、動画などをWebサーバに要求して、内容に応じてWebサーバがレスポンスを返します。レスポンスを受け取ったWebブラウザは画面上にページや画像、動画などを表示します。

5. クローラーブロック対策

クローラーエンジニアはクローラーを開発する人と言っても、クローラーブロック対策を了解するのも重要です。一般的なクローラーブロック対策は次のとおりです。

(1)アクセス頻度制限

頻繁にアクセスする場合、WebサイトがこのIPをしばらくブロックすることがあります。その一方、クローラーを開発するとき、クローラーが人間のような頻度でWebページにアクセスするようにしようとすることができます。

(2)ログイン制限

ログインのステップを追加位して、クローラーのアクセスを拒否するのは普通ですね。ただし、現在のクローラーは、ログインをシミュレートし、Cookieを追加することでログインを解決することもできます。

(3)Header制限

通常、SafariやChromeなどのブラウザを使ってWebサイトにアクセスする場合、Headerやオペレーティングシステムの情報があります。クローラーでアクセスする場合、そのようなHeaderはありません。

(4)動的なJavaScriptコンテンツ

一部のWebページにはJavaScriptを介して生成されるコンテンツがあります。つまり、JavaScriptを使うと、新しいコンテンツが表示されたり変化します。このような動的なWebページをスクレイピングするのは難しいです。

(5)CAPTCHA

CAPTCHAはコンピューターと人間を区別するバクロニムです。ゆがんだ文字列と数字が使われるCAPTCHAは人間にとって理解しやすいですが、クローラーにとってそれを認識するのが難しいです。

(6)IP制限

この方法では、特定のIPが永久にブロックされる場合がありますが、実際のユーザーに迷惑をかけてしまう可能性があります。

まとめ

いかがでしたか?クローラーエンジニアは思ったような退屈な仕事ではなく、学ぶべきこともたくさんありますね。

もちろん、社内のエンジニアリソースが足りないであったり、そもそも技術的なスタッフがいなったり、わざわざエンジニアを雇う予算がない場合もあります。幸いに、OctoparseのようなWebクローラーツールを使って、誰でもクローラーを開発でき、誰でもクローラーエンジニアになれます。自社にノウハウがないが、課題解決にデータを収集したい場合は、ぜひWebクローラーツールを試してみてください。

スタートアップの成長におけるビッグデータの活用

ビッグデータの時代に、スピードが加速する今日のビジネスでは24時間体制で業務を続けるのも不十分です。スタートアップは、この激しい競争の中で生き残りたいなら、ビッグデータの急速な進歩に遅れをとらず、自社の強みを把握し、自社事業の持続的な成長が勝利の鍵です。

ビッグデータとは、大量(Volume)、多種類(Variety)、高頻度(Velocity)のデータのことを指します。ビッグデータの活用によって、社内のビジネスプロセスを改善し、業界の関連情報に素早くアクセスすることができます。

しかし、多くの企業は新しいテクノロジーを導入するコストを過大評価し、そのビッグデータをGoogle、Amazon、Facebook、Appleなどの巨大企業の特権と見なしています。実は、ビッグデータはスタートアップの成長に必要なリソースを提供しています。

そうした状況を鑑みて、本記事では、ビッグデータは、スタートアップの成長にどのように役立つのかという問題を説明します。

1. 業界の動向を把握する

どんな業界でも、業界の動向を調査して予測できることは避けられません。起業家としての最も経済的な方法は、ビッグデータを活用して、業界情報を把握できるようにすることです。Googleトレンドは、起業家が業界内の発展トレンドを理解するのに役立つ便利なツールです。

Googleトレンドでは、特定の期間におけるサイトの合計検索ボリュームに対して、特定の検索キーワードがどれくらい検索されているのかを示します。

Googleトレンドを使うと、ユーザーがどのキーワードを検索しているか、どのようにトレンドが推移しているか見えます。それに、国や地域、関連キーワードやトピックも見えます。経営経験が短かくデータ量が少ない企業にはGoogleトレンドは重要な集客ツールとなり、マーケティング対策にも活用できます。ぜひ活用してみてください。

2. マーケティング効率を高める

市場シェアを拡大し、ターゲットグループを拡大することは、スタートアップの成長に不可欠です。限られた予算の中で、マーケティングの効果を最大化する方法は?ビッグデータを利用すると、顧客になる可能性が極めて低い人を広告配信の対象から除外することができます。AllSightなどの顧客インテリジェンスツールを使うと、企業が広告キャンペーンにお金を無駄にするのを防ぐことができます。

AllSightは、顧客データを管理するためのAI駆動型のプラットフォームです。最新のテクノロジーを使用して、断片化されたデータをシステムに統合し、インテリジェンスプラットフォームで強化します。マーケティング担当者と経営者は、企業はエンタープライズ規模の顧客データとアナリティクスの活用を通じて、ターゲットグループをよりよく理解して、これまで以上に充実した長期にわたる顧客関係を構築でき、自社製品を効果的に宣伝できるようになりました。

3. 社内コラボレーションを強化する

効果的な社内コラボレーションは、スタートアップ企業にとって重要な役割を果たします。なぜなら、社内コミュニケーションをを改善し、生産性向上や業務効率化させることができるからです。社内コミュニケーションが良くない会社は、働き雰囲気が良くないというだけでなく、意思疎通や相互理解の不足から、業務効率が低下するリスクもあり、スムーズに発展することが難しいです。

ビッグデータやクラウドストレージの発展とともに、チームメンバーはファイル、ドキュメント、その他の情報を共有できるようになりました。GoogleドライブとGoogleドキュメントは、メンバーの共同作業に役立ちます。

たとえば、Googleドキュメントは、ドキュメントやスプレッドシートをオンラインで作成、編集、保存できる無料のWebベースのアプリケーションです。Google ドキュメント、 スプレッドシート、スライドを使って、世界中のあらゆる場所からリアルタイムで他のメンバーと共同作業ができます。

4. カスタマービューを生成する

マーケティングとは、適切なタイミングで適切な顧客にリーチすることであるため、ビッグデータを活用して、購入を予測し、顧客の行動を分析し、製品を購入する人々をよりよく理解できます。ビッグデータを使うと、顧客の包括的なビューを簡単に作成することができます。

アプローチの1つは、ビッグデータは顧客の記録や選択を追跡し、顧客のニーズを予測し、それぞれに合わせた商品を勧めるために用いられます。2012年には、How Target Figured Out A Teen Girl Was Pregnant Before Her Father Didという有名なケースがあります。小売大手「ターゲット」は、女子高校生の買い物履歴から、妊娠しているのを予測し、ベビー用品のクーポンを送信しました。

それに、ビッグデータにより、起業家は製品に関する顧客の意見を了解し、製品と業務プロセスを改善できるようになりました。たとえば、Appleの新製品を体験した後、TwitterやFacebookなどのソーシャルメディアで感想を発表することがよくあります。Apple Incが、ユーザーの声を知りたいなら、ソーシャルメディアから意見を収集することは良い選択です。

OctoparseなどのようなWebスクレイピングツールを使うと、コーディングせずにTwitterからツイートやコメントを簡単に抽出し、ダウンロードできます。世間の声を分析することで、カスタマーエクスペリエンスを向上させることができます。

とにかく、ビッグデータは、スタートアップ企業が効率性や収益性を高めるのに役立ちます。競争が激しい現代の市場において、競争優位性を生み出すために、ビッグデータを活用してみてください。